諸君は,物やエネルギーの伝達はよく知っている.トラックや鉄道を使った工業製品の輸

送(伝達)は説明するまでもなく,よく見る光景である.電線を使った電力の輸送(伝達)も

理解しているだろう.前者はある定まった物が送られ,後者はエネルギーが送られる.

それに対して,携帯電話のメールで送られるものは何だろうか? 言うまでもなく,送られ

る物は情報である.これもある程度理解できるであろう.

問題は,送られる情報を定量的に取り扱う方法を見いだすことである.物の伝達であれば,

質量や体積で取り扱うことができる.エネルギーであれば,ジュール(Jule)という単位で取り扱

うことができる.情報はどのような単位で取り扱えばよりのだろうか?

情報の取り扱いが学問になるためには,それを定量的に表現しなくてはならない.次節か

ら,情報を定量的に取り扱う方法を述べる.

全く同じメッセージを受け取っても,受け手によって情報量は異なる.例えば,次

のような状況を考えよう.

- まじめな,A君とC君は講義をよく聞いている.先生の発言「今回の試験では,教科書の203ペー

ジから223ページから出題する」を聞き逃さなかった.

- 一方,B君は講義中,ほとんど寝ている.

- 学年末試験までに講義で取り扱った内容は,教科書のp.153-253であった.B君は

100ページも勉強しなくてはならないと思い憂鬱な気分であった.

- 昼休憩にA君とB君,C君が話をしていた.図1のような場面があった.

図 1:

同じ情報でも,人により得る情報量が異なる.あらかじめそれを知っていたA

君が得る情報はゼロであるが,知らなかったB君は多くの情報を得る.

|

|

A君とB君は,全く同じメッセージをC君から受け取った.しかし,A君はすでに知っている

内容で,A君の情報量は全く増加しない.それに対して,このメッセージでB君はとてつも

なく大きな情報を得たことになる.

それでは,情報の大きさの大小関係を考えてみよう.先ほどの例から,次のようなことが

分かるだろう.

メッセージを受け取ることにより,何かを知ることになる.「驚き」の多いメッセージ

ほど,大きな情報量がある.

今まで無かった情報を得たときに,人間は驚く.まったく,知識が無いことを得ると驚き

は大きくなる.今のところ,情報量を「驚き」というような,およそ学問とは関係なさそ

うな人間の感情で表している.あとで,分かるがこれを手がかりに情報量を定量的に評価

してする.

大小関係が分かったので,次の節から情報量を定量的に定義する.

このあたりは教科書 [1]のpp.38-41に沿って説明する.教科書をにらみながら理解

せよ.プリントのみでは理解できない.

教科書のp.39の内容をまとめると,次のようになる.

- 歴史のテストがある.歴史は,日本史と東洋史,西洋史,アメリカ史がある.そ

れぞれの出題確率は,1/4である.

- 世界史とは,日本史以外,すなわち東洋史と西洋史,アメリカ史のことである.

このような状況の中で,メッセージにより受け取る情報量を考える.

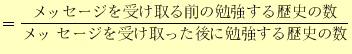

先ほどの例(A君とB君,C君)から,受け取る情報量は

とすることができるだろう.これは,メッセージを受け取ることにより驚きを表している

ことになる.例えば,次のような例である.明日,歴史のテストがある状況で,教師が次

のようなメッセージを発信した.

- (A)

- 明日は歴史のテストがあるので勉強してくるように.

- (B)

- 明日の歴史のテストは,アメリカ史に限る.

式(1)の定義によると,(A)の場合の受け取る情報量は1で,(B)の場合

は4である.明らかに(B)のメッセージの方が情報が多いので,式(1)

で情報量を定義しても良さそうである.

実は,式(1)が不便な場合がある.次のように2段階にメッセージが発

信された場合である.

- (i)

- 明日の歴史のテストは,世界史(東洋史,西洋史,アメリカ史)を出題する.

- (ii)

- 東洋史と西洋史は出さない.

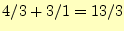

これで受け取る情報量を計算してみよう.(i)のメッセージでは, の情報を受け取る.

(ii)のメッセージでは,

の情報を受け取る.

(ii)のメッセージでは, のの情報を受け取る.

のの情報を受け取る.

それでは,(i)と(ii)の二つのメッセージで合計,どれだけの情報を受け取ったのであろ

うか?

と考えて良いだろうか? これはまずい.なぜならば,(i)と(ii)を

あわせたメッセージは,先の(B)のメッセージと同じ内容である2.にもかかわらず,情報量が異なる.

と考えて良いだろうか? これはまずい.なぜならば,(i)と(ii)を

あわせたメッセージは,先の(B)のメッセージと同じ内容である2.にもかかわらず,情報量が異なる.

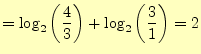

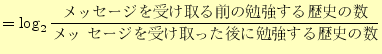

解決の方法は,

と定義すればよい.対数の底は2である必要は無い.しかし,コンピューター科学では0と1の2進

数を使うので,2とすると後々便利なことが多い.こうすることにより,

| (B)のメッセージの情報量 |

|

(3) |

| (i)と(ii)のメッセージの情報量 |

|

(4) |

となり,まことにハッピーな結果が得られる.

|

ものいい

ちょっと待った! (i)と(ii)の発言により得られる情報量を

とすれば,式

(1)の定義でも良いのではないか? 確かに,2つの情報を得たときの

演算を乗算で定義すれば,情報量を式(1)のように定義しても矛盾は

ない.しかし,情報は加えることができる--と言うことを考えると,二つの情報は加算

を行う方がしっくりくる.一般に量は,加算ができる方がいろいろと便利である.どの

ような量も二つの物を合計するときは加算の演算を行う.従って,加法性を受け入れる

ならば,情報量は式(2)で定義すべきである. とすれば,式

(1)の定義でも良いのではないか? 確かに,2つの情報を得たときの

演算を乗算で定義すれば,情報量を式(1)のように定義しても矛盾は

ない.しかし,情報は加えることができる--と言うことを考えると,二つの情報は加算

を行う方がしっくりくる.一般に量は,加算ができる方がいろいろと便利である.どの

ような量も二つの物を合計するときは加算の演算を行う.従って,加法性を受け入れる

ならば,情報量は式(2)で定義すべきである.

|

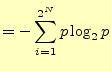

次に述べる確率による定義がもっとも一般的に情報量のとして使われる.確率 で起きる事実を知ったときに得られる情報量は,

で起きる事実を知ったときに得られる情報量は,

情報量![$\displaystyle =-\log_2p\quad[\mathrm{bit}]$](img11.png) |

(5) |

である.

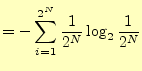

それでは,先の(B)のメッセージと(i)と(ii)を加えたメッセージで,この確率による情報

量を計算してみよう.

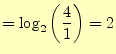

- (B)の場合.アメリカ史が出題される確率は1/4であった.(B)のメッセージにより,

出題内容はアメリカ史に限定された.

(B)のメッセージの情報量![$\displaystyle =-\log_2\left(\frac{1}{4}\right)=2\quad\mathrm{[bit]}$](img12.png) |

(6) |

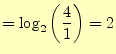

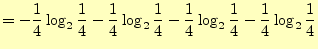

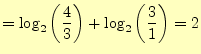

- (i)と(ii)の場合.(i)の「世界史を出題する」は3/4の確率の事実である.(ii)の「アメリカ

史に限る」はそのときは1/3の確率である.

(i)と(ii)のメッセージの情報量![$\displaystyle = -\log_2\left(\frac{3}{4}\right)-\log_2\left(\frac{1}{3}\right)=2\quad\mathrm{[bit]}$](img13.png) |

(7) |

次にメッセージを受け取ったときに得る情報量を計算しよう.これは,後で述べる情報の

圧縮と密接に関わっている.

一つのメッセージを受け取っ

たときにいつも情報量が同じとは限らない.二つの場合について,メッセージに含まれる

平均情報量3,すなわちメッセージを受け取ることにより得られる情報量の期待値を

計算してみよう.ここで, はメッセージ

はメッセージ が生じる確率である.当然,

が生じる確率である.当然,

|

(9) |

となる.

受け取る情報が,「日本史」か「東洋史」,「西洋史」,「世

界史」の4通りでそれぞれ等確率の場合を考える.このとき,受け取るメッセージを次のように符号化する.

日本史

00 00 |

東洋史

01 01 |

西洋史

10 10 |

アメ

リカ史

11 11 |

この場合,メッセージに含まれる平均情報量は

| 平均情報量 |

|

|

| |

![$\displaystyle =2\,\mathrm{[bit]}$](img23.png) |

(10) |

となる.符号化の2進数の桁数と同じ.

受け取る情報が,「日本史」か「世界史(東洋史・西洋史・ア

メリカ史)」の二通りで,確率は1/4と3/4である.受け取るメッセージは,次のように符号化する.

日本史

0 0 |

世界史

1 1 |

|

|

この場合,メッセージに含まれる平均情報量は

となる.平均的に受け取るメッセージは,符号化の2進数の桁数よりも小さくなる.「日

本史」は2[

]の情報があるが,「世界史」の情報は0.415[

]の情報があるが,「世界史」の情報は0.415[

]である.

]である.

このように,受け取るメッセージの確率が異なる場合,受け取る平均情報量が2進数で符

号化した場合の桁数よりも小さくなることがある.一方,確率が等しい場合は,平均情報

量と2進数で符号化した場合の桁数は同一となる.このあたりは,教科書 [1]

pp.43の図3.3を見よ.

|

コーヒーブレイク

平均情報量を表す式(8)に関して,ファインマンの教科書

[2]にはおもしろいことが書かれている.この式は,統計力学(熱

力学)のエントロピーの式とほとんど同じである--と言う知識を前提に,以下引用する.

シャノンはこの平均情報量を「情報のエントロピー」と呼んだが,これを大きな間違い

だったと思う人がいる.というのは,これによって多くの人が情報理論と熱力学との関

連を強調しすぎることになったからである.

また,次のようなことも書いてある.

言い伝えによれば,シャノンはこの用語を,数学者フォン・ノイマンの助言によって採

用した.フォン・ノイマンは「ともかく誰も実際にエントロピーが何なのかがわからな

いので この用語によってシャノンは論争に優位に立つだろう」と公言したとい

うことである. この用語によってシャノンは論争に優位に立つだろう」と公言したとい

うことである.

|

先に述べたように,メッセージは2進数で符号化できる.現代のデジタル化した情報社会

では,この符号化したデータを送受信することにより,情報のやりとりを行っている.

送受信のコストを下げるためには,できるだけ少ないデータ;2進数の桁数が小さいで,多

くの情報を送らなくては成らない.ここでの問題は,平均情報量が分かった場合,必要な

2進数符号の桁数は? どのようにすれば2進数符号の桁数を最小にできるか?である.

先ほどの二つの問いは,データ圧縮の問題そのものである.データ圧縮は,最小のデータ

で最大の情報を表す方法である.

メッセージを2進数で符号化する. 種類目のメッセージ

種類目のメッセージ の符号の桁数を

の符号の桁数を とする.この場合,平均符号長は,

とする.この場合,平均符号長は,

平均符号長 |

(12) |

となる.この平均符号長さは,そのメッセージの平均情報量は ビットを超えることが

できない.なぜならば,

ビットを超えることが

できない.なぜならば, 桁の2進数;符号長で表すことのできる最大情報量は

桁の2進数;符号長で表すことのできる最大情報量は ビットである

からである.

ビットである

からである.

これがデータ圧縮の限界を表す.教科書の例はハフマン符号化を行い,平均符号長を平均

情報量に近づけている.

ハフマン符号化については,省略する.ただし,課題にそれがあるので調べよ.

0と1が同じ確率で発生するメッセージの場合,2進数の桁数と情報量が同じであることを

示そう.0と1の発生確率が同じ 桁の2進数の場合,ある特定のパターンの2進数が発生

する確率

桁の2進数の場合,ある特定のパターンの2進数が発生

する確率 は,

は,

|

(13) |

である.従って,どのようなパターンのメッセージを受け取っても,得られる情報は

となる.この場合,2進数の桁数と情報量が同一となる.

ホームページ: Yamamoto's laboratory

著者: 山本昌志

Yamamoto Masashi

平成19年12月7日

![]() と考えて良いだろうか? これはまずい.なぜならば,(i)と(ii)を

あわせたメッセージは,先の(B)のメッセージと同じ内容である2.にもかかわらず,情報量が異なる.

と考えて良いだろうか? これはまずい.なぜならば,(i)と(ii)を

あわせたメッセージは,先の(B)のメッセージと同じ内容である2.にもかかわらず,情報量が異なる.

![$\displaystyle =-\log_2\left(\frac{1}{4}\right)=2\quad\mathrm{[bit]}$](img12.png)

![$\displaystyle = -\log_2\left(\frac{3}{4}\right)-\log_2\left(\frac{1}{3}\right)=2\quad\mathrm{[bit]}$](img13.png)

![]() 種類目のメッセージ

種類目のメッセージ![]() の符号の桁数を

の符号の桁数を![]() とする.この場合,平均符号長は,

とする.この場合,平均符号長は,